Les biais algorithmiques ou comment le code peut être discriminant ?

Depuis que le numérique occupe une place de choix dans notre société, les acteurs de la tech ont un rôle qui dépasse le strict univers technique. En effet, ils codent et développent des logiciels qui impactent la société.

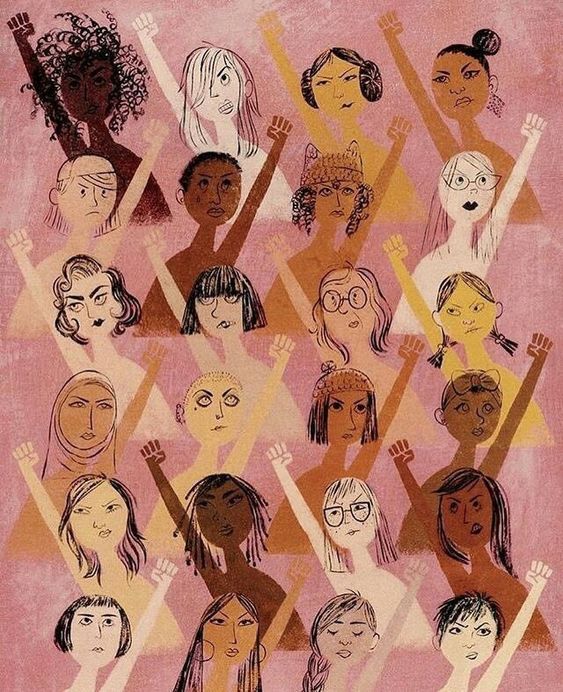

Ils deviennent et doivent impérativement devenir des acteurs de l'inclusion. Et pour cause : un bon nombre de logiciels sont discriminants envers les femmes mais aussi envers diverses minorités et communautés.

Aujourd’hui, les sociétés sont confrontées à deux grands défis : la protection des données personnelles sur les plateformes numériques et les risques des biais algorithmiques discriminants.

On peut tous être confrontés à des discriminations et on peut tous transmettre des stéréotypes. Il faut en prendre conscience pour créer un monde plus inclusif et diversifié. Pour cela, focus sur les biais algorithmiques discriminants et leurs conséquences.

C’est quoi les biais algorithmiques ?

Déjà, commençons par le plus simple : qu’est qu’un algorithme ?

Il s’agit d’une suite d’opérations qui permet d’obtenir un résultat. Aujourd'hui, les algorithmes de machine learning prennent de l'ampleur. Il s'agit de logiciels qui apprennent seuls, en créant eux-même des chemins pour arriver à un résultat.

Un biais est l'écart entre ce que dit l'algorithme et la réalité, explique simplement l'Institut Montaigne. Malheureusement, ils peuvent entraîner des discriminations, en offrant un résultat différent selon ton genre, ta couleur de peau, ta religion, ton orientation sexuelle etc... Ce qui va totalement à l'encontre de l'inclusion.

Une petite mise en situation s'impose : Spotify ou Deezer possèdent de nombreux algorithmes qui permettent de te constituer automatiquement une playlist avec tes chansons préférées. Enfin, celles qui seraient SUSCEPTIBLES de te plaire ! Or, ce n'est pas toujours le cas et heureusement que tu peux encore farfouiller pour trouver ta perle rare. Dans ce cas là, il ne s'agit pas de biais algorithmiques discriminant mais simplement d'une volonté de l'algorithme de t'orienter vers des choix qui peuvent te plaire. Ces choix ne sont pas ta réalité, c'est pourquoi il s'agit d'un biais.

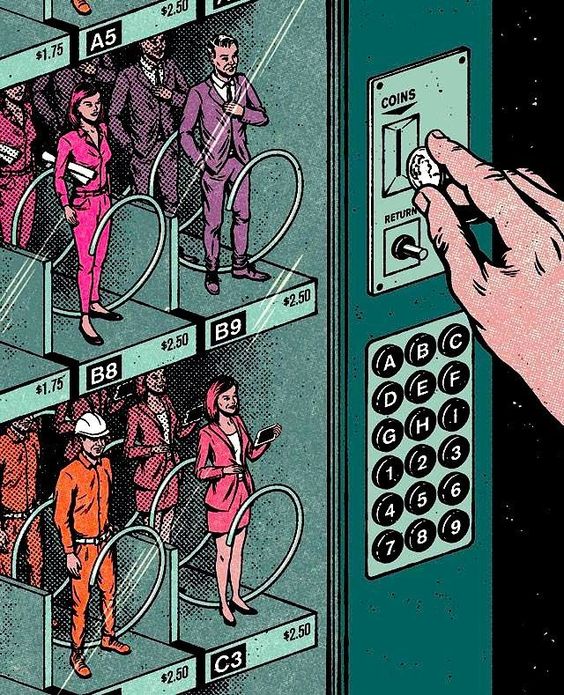

Prenons une autre situation concrète. Certains algorithmes de recrutement sont créés en prenant en considération les caractéristiques principales des personnes qui exercent un métier. Si l'on suit cette démarche à la lettre, dans le domaine du numérique, où les profils sont majoritairement masculins (70%), l'algorithme pourra conclure que le critère du genre entre en compte pour sélectionner des candidats.

Et donc ici, on pourrait se retrouver face à un algorithme qui discrimine les femmes à l'emploi. Alors que ta candidature mérite tout de même un petit coup d'oeil, non?

Des exemples d'algorithmes discriminants

Pour que tu comprennes vraiment à quel point ces biais algorithmiques discriminants sont présents autour de toi, nous avons décidé de te donner quelques exemples assez marquant.

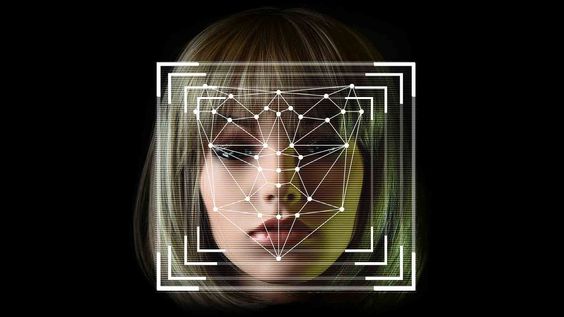

- En janvier 2020, un homme nommé Robert Williams est arrêté à Détroit à cause d'un logiciel ayant jugé que son visage était identique à la photographie d'un voleur de montres, prise par une caméra de surveillance. Il passe 30 heures en garde à vue. Or, il ne s'agissait pas de la bonne personne. Selon la fondatrice du groupe d'activiste Algorithmic Justice League, Joy Buolamwini, il s'agit d'une démonstration "de la façon dont le racisme systémique peut être encodé et reflété dans les intelligences artificielles" . En effet, comme rapporte Maddyness, une étude du Massachussets Institute of Technology de 2018 a démontré que les principaux logiciels de reconnaissance faciale comportaient des biais algorithmiques dangereux : la marge d'erreur dans la reconnaissance des hommes blancs était de 1% quand celle des femmes noires était de 35%. C'est très grave lorsqu'il s'agit de priver un individu innocent de ses libertés !

- Joy Buolamwini, doctorante au Média Lab du MIT, a mené une autre enquête plus qu'intéressante sur la reconnaissance faciale. En tant que femme noire, elle explique que la majorité des logiciels de reconnaissance faciale ne reconnaissent pas son visage, elle doit donc porter un masque blanc pour être détectée. Elle a donc analysé comment les algorithmes de machine learning créent des discriminations. Tout d'abord, les developpeurs-ses, programmateurs doivent montrer différents visages aux ordinateurs pour qu'ils puissent ensuite apprendre à en reconnaître pleins d'autres différents. Or, si les visages-exemples ne sont pas diversifiés, l'algorithme aura beaucoup de mal à détecter des visages aux caractéristiques variées. D'où l'importance d'une équipe de développement mixte et soucieuse de ces biais algorithmiques, on y reviendra.

- Comme nous l'expliquait Isabel Collet, les premiers GPS reconnaissaient difficilement les voix de femmes. La raison : les programmeurs avaient utilisé une voix d'homme pour coder l'algorithme. Les femmes ont longtemps pensé qu'elles n'étaient pas douées avec la technologie. C'est faux. Elles ont simplement été victimes de biais algorithmiques discriminant.

- Un autre exemple de biais algorithmiques discriminant : l'application de reconnaissance faciale d'Apple a été programmée pour que ton téléphone reste verrouillé si tu dors ou est inconscient(e). Problème : les personnes aux yeux bridés ne pouvaient jamais déverrouiller leur téléphone via cette technologie et se voyaient obliger d'écarquiller grand les yeux pour que ça fonctionne. Pas très inclusif comme démarche pour une entreprise dont le rêve est de conquérir le monde entier !

Comme tu peux le voir, les situations discriminantes dues à la programmation sont nombreuses. Mais l'important est de garder en tête que des solutions existent. Tu peux clairement changer la donne.

En effet, le sujet devient de plus en plus d'actualité et des organismes influents délivrent des recommandations pour contrer le fléau des biais algorithmiques discriminants.

Comment créer des algorithmes inclusifs ?

L'institut Montaigne a formulé des recommandations pour rendre les algorithmes plus équitables. Tout d'abord, il faut absolument pouvoir mesurer l'impact des biais algorithmiques car il existe peu d'études sur le sujet.

Puis, la protection contre ces biais discriminants nécessite l'adoption de bonnes pratiques et la formation des développeur·se·s.

Selon cet Institut, il faudrait donc mettre en place rapidement les recommandations suivantes, dans un objectif d'inclusion :

- Prévenir la diffusion de biais algorithmiques en commençant par communiquer sur le problème : création de chartes internes, évaluations et analyses de l'algorithme, liste de questions à se poser pour éviter les biais discriminants. D'ailleurs, à ce propos, Aequitas propose un arbre à questions pour évaluer tes algorithmes et offre des solutions de correction adaptées. Par exemple, il faut se poser des questions de type : quels sont les taux d'erreurs pour les différents sous-groupes d'utilisateurs ? Quels processus sont mis en place pour gérer les erreurs ? Suis-je personnellement responsable de la création de ce biais discriminant ?

- Former les techniciens et ingénieurs aux risques des biais algorithmiques : une grande responsabilité repose sur les créateurs de ces algorithmes. Mais pas que. En effet, c'est la responsabilité de tous les maillons de la "chaîne algorithmique", en passant par les professionnels mais aussi les citoyens, rappelle un rapport de la CNIL (Commission Nationale de l'Informatique et des Libertés), qui peuvent et doivent rapporter les biais dont ils sont victimes. Les écoles, en particulier les écoles d'informatique, doivent aussi sensibiliser les prochains programmeurs aux risques des biais algorithmiques discriminants et leur apprendre à coder de manière inclusive.

- Tester les algorithmes avant utilisation, à l'image des médicaments : parfois, il est impossible de se rendre compte de l'impact d'un algorithme. Il faut donc le tester pour s'assurer de son équité et de sa capacité d'inclusion, et ceci à large échelle avec des équipe de testeurs diversifiés.

- Evaluer les biais dans les méthodologies de création en mettant à disposition des entreprises des bases de données publiques de test : par exemple, la base de données sur la reconnaissance faciale délivrera une méthodologie pour vérifier l'absence de discriminations basées sur le genre ou l'ethnie. Cette recommandation a aussi été jugée utile par la CNIL.

- Elaborer un cadre limitatif et être plus exigeant avec les risques des algorithmes à fort impact, c'est à dire ceux qui touchent à des services essentiels : la sécurité, la santé, la justice. A côté, il faudrait demander à l'Etat de contrôler ces algorithmes.

- Soutenir la mise en place de labels et certifications d'équité ou d'inclusion des algorithmes pour renforcer la confiance des citoyens.

La CNIL (Commission Nationale de l'Informatique et des Libertés) avait déjà élaboré une liste de recommandations en 2017 pour contrer rapidement ces discriminations graves.

En voici quelques exemples :

- Rendre les systèmes algorithmiques accessibles et open-source en usant de la médiation avec les citoyens

- Renforcer la fonction éthique au sein des entreprises

Comme tu le vois, des solutions existent. La diversité des équipes de développeurs·se·s est également une réponse efficace au problème des biais algorithmiques discriminants, puisque la question de l'inclusion peut ainsi être soulevée bien en amont.

Diversité et inclusion : l'intérêt d'une équipe mixte

Soyons honnêtes, une personne même ouverte d'esprit ne pourra jamais comprendre et faire valoir les caractéristiques de toute une population. C’est humain.

Nous connaissons notre environnement mais pas forcément celui de tous les individus d'une société, même en étant le plus curieux du monde. C’est aussi ça qui fait la beauté d’une société aussi diversifiée que la France. Cela te permet d'apprendre tous les jours.

Or, il faut être conscient que tu véhicules parfois des stéréotypes. Le top pour t'aider : intégrer une équipe mixant les cultures, les ethnies, les religions, les orientations sexuelles, les genres, etc.

Les équipes diversifiées sont forcément plus inclusives. En effet, elles permettent de comprendre une plus grande proportion de la population et de coder avec bienveillance. C'est d'ailleurs pour cela que les équipes mixtes sont plus performantes.

C'est parfois difficile de recruter des profils variés. Surtout quand des biais algorithmiques discriminants au sein du recrutement nous en empêchent.

Il faut donc mettre les bouchées triples et investir dans un recrutement inclusif pour attirer plus de talents. Pour cela, tous les types de publics doivent pouvoir accéder à une formation, surtout dans un univers encore très masculin comme la tech.

Ada Tech School propose aux femmes et hommes de devenir des développeur·se·s engagé·e·s, soucieux·se·s des problématiques de diversité et d'inclusion tout en offrant un bagage technique de qualité.

Vous pouvez télécharger notre brochure de présentation et assister à une conférence en ligne pour en savoir plus sur la pédagogie d'Ada Tech School.

À propos d'Ada Tech School

Ada Tech School est une école d’informatique d’un nouveau genre. Elle s’appuie sur une pédagogie alternative, approchant le code comme une langue vivante, ainsi que sur un environnement féministe et bienveillant. Elle doit son nom à Ada Lovelace qui fut la première programmeuse de l’histoire.

L’école est située à Paris, Nantes et Lyon et accueille chaque promotion pour deux ans. Après neuf mois de formation les étudiants sont opérationnels et prêts à réaliser leur apprentissage - rémunéré - pendant douze mois dans une des entreprises partenaires de l’école comme Trainline, Deezer, Blablacar ou encore Botify. Aucun pré-requis technique n’est exigé pour candidater. Il suffit d’avoir plus de 18 ans. La sélection se fait en deux temps : formulaire de candidature puis entretien avec une réponse sous 2 semaines. Pour plus d’informations sur la formation, télécharge notre brochure de présentation.